Những điểm chính

- Thiên vị thuật toán: Hiểu rõ các sai lệch hệ thống trong AI có thể dẫn đến quyết định không công bằng, bắt nguồn từ dữ liệu huấn luyện và thiết kế của con người.

- Ảo giác AI: Nhận biết rủi ro khi các mô hình AI tạo sinh tạo ra thông tin sai lệch một cách đầy thuyết phục, gây nguy hiểm cho các quyết định kinh doanh quan trọng.

- Giải pháp kỹ thuật: Áp dụng các phương pháp như kiểm toán dữ liệu, kỹ thuật RAG (Retrieval-Augmented Generation), và RLHF để giảm thiểu thiên vị và ngăn chặn ảo giác.

- Quản trị có trách nhiệm: Xây dựng các đội ngũ giám sát đa dạng, thực hiện kiểm toán thường xuyên và tuân thủ các quy định để đảm bảo AI được triển khai một cách công bằng và minh bạch.

Mục lục

- 1. Thiên vị Thuật toán (Algorithmic Bias) là gì?

- 2. Giải mã “Ảo giác” của Mô hình AI (AI Hallucinations)

- 3. Dữ liệu Thị trường và Xu hướng Hiện tại (2025)

- 4. Phương pháp Tốt nhất: Giảm thiểu Thiên vị trong Mô hình AI

- 5. Ngăn chặn “Ảo giác” trong Mô hình Ngôn ngữ Lớn

- 6. Câu chuyện Thành công: Từ Nhận thức đến Hành động

- 7. Dự báo Tương lai và Hành động cho Doanh nghiệp

- Câu hỏi thường gặp

Trí tuệ nhân tạo (AI) đang ngày càng trở thành một phần không thể thiếu trong các quy trình ra quyết định quan trọng của doanh nghiệp, từ tuyển dụng, chấm điểm tín dụng đến chẩn đoán y tế. Tuy nhiên, đằng sau lời hứa về hiệu quả và độ chính xác vượt trội là hai rủi ro tiềm ẩn nhưng cực kỳ nghiêm trọng: thiên vị thuật toán (algorithmic bias) và “ảo giác” của mô hình AI (AI model hallucinations). Thiên vị có thể vô tình tạo ra các quyết định phân biệt đối xử, gây tổn hại đến danh tiếng và pháp lý. Trong khi đó, ảo giác có thể đưa ra những thông tin sai lệch một cách đầy thuyết phục, dẫn đến những chiến lược kinh doanh sai lầm. Việc hiểu rõ và chế ngự sự khó đoán này không còn là một lựa chọn, mà là yêu cầu bắt buộc để xây dựng các hệ thống AI đáng tin cậy, công bằng và thực sự hiệu quả. Bài viết này sẽ phân tích sâu về bản chất, nguyên nhân và tác động của hai hiện tượng này, đồng thời cung cấp một lộ trình chi tiết để các nhà lãnh đạo có thể kiểm soát rủi ro và khai thác tối đa tiềm năng của AI.

1. Thiên vị Thuật toán (Algorithmic Bias) là gì?

Thiên vị thuật toán mô tả các xu hướng sai lệch có hệ thống và lặp lại trong các hệ thống AI, dẫn đến những kết quả không công bằng cho các cá nhân hoặc nhóm cụ thể. Những sai lệch này xảy ra khi các thuật toán học máy tạo ra các kết quả phân biệt đối xử, phản ánh, duy trì hoặc thậm chí khuếch đại các định kiến xã hội, sự bất bình đẳng hoặc các giả định dữ liệu thiếu sót đã tồn tại từ trước.

Nguồn gốc của Thiên vị

Thiên vị không tự sinh ra trong thuật toán mà bắt nguồn từ chính dữ liệu và quy trình do con người tạo ra. Các nguồn gốc chính bao gồm:

- Dữ liệu huấn luyện có sẵn định kiến: Nếu dữ liệu dùng để đào tạo AI phản ánh các định kiến trong quá khứ (như phân biệt chủng tộc, giới tính), mô hình sẽ học và tái tạo lại những định kiến đó.

- Lựa chọn biến đại diện (Proxy variable): Sử dụng các biến gián tiếp có tương quan với các thuộc tính nhạy cảm (ví dụ: dùng chi phí chăm sóc sức khỏe thay vì nhu cầu sức khỏe thực tế) có thể vô tình tạo ra sai lệch hệ thống.

- Lựa chọn của nhà phát triển: Các quyết định trong quá trình mã hóa và diễn giải của các kỹ sư có thể vô tình đưa các thành kiến cá nhân hoặc xã hội vào mô hình.

- Định kiến có sẵn trong xã hội: Các thuật toán dựa trên các quyết định lịch sử hoặc logic pháp lý có thể kế thừa và tự động hóa những định kiến đã tồn tại trong các thể chế.

Những ví dụ Thực tế Gây Chấn động

- Thuật toán Y tế: Một thuật toán được sử dụng trong các bệnh viện ở Mỹ để dự đoán bệnh nhân nào cần chăm sóc đặc biệt đã ưu tiên cho bệnh nhân da trắng hơn bệnh nhân da đen. Nguyên nhân là vì thuật toán được huấn luyện dựa trên lịch sử chi phí y tế, mà bệnh nhân da đen trong lịch sử thường nhận được ít sự chăm sóc hơn và do đó có chi phí thấp hơn, mặc dù nhu cầu sức khỏe tương đương. Việc điều chỉnh lại thuật toán đã giúp tăng gần gấp đôi số lượng bệnh nhân da đen được chọn để hỗ trợ.

- Công cụ Tuyển dụng: Công cụ tuyển dụng bằng AI của Amazon đã bị phát hiện phạt các hồ sơ có chứa từ “women’s” (của phụ nữ) và hạ thấp ứng viên tốt nghiệp từ các trường đại học dành cho nữ. Điều này xảy ra do dữ liệu huấn luyện trong 10 năm chủ yếu là hồ sơ của nam giới.

- Hệ thống Tư pháp: Thuật toán COMPAS được sử dụng tại các tòa án Mỹ đã dự đoán sai nguy cơ tái phạm đối với các bị cáo da đen cao hơn nhiều so với các bị cáo da trắng, ảnh hưởng trực tiếp đến các quyết định tuyên án và ân xá.

Ví dụ về thiên vị là một trong những lý do chính khiến các dự án AI không đạt được mục tiêu và gây ra hậu quả tiêu cực. Tìm hiểu thêm về những cạm bẫy khiến dự án AI thất bại.

Tác động đến Doanh nghiệp

Thiên vị thuật toán làm xói mòn lòng tin của công chúng, đặt các tổ chức trước những rủi ro pháp lý, tài chính và danh tiếng nghiêm trọng, đồng thời phá vỡ các hoạt động kinh doanh công bằng. Các khung pháp lý như Đạo luật AI của EU (EU AI Act) có thể áp đặt các khoản phạt lên tới hàng triệu euro cho việc triển khai AI thiên vị hoặc không công bằng.

2. Giải mã “Ảo giác” của Mô hình AI (AI Hallucinations)

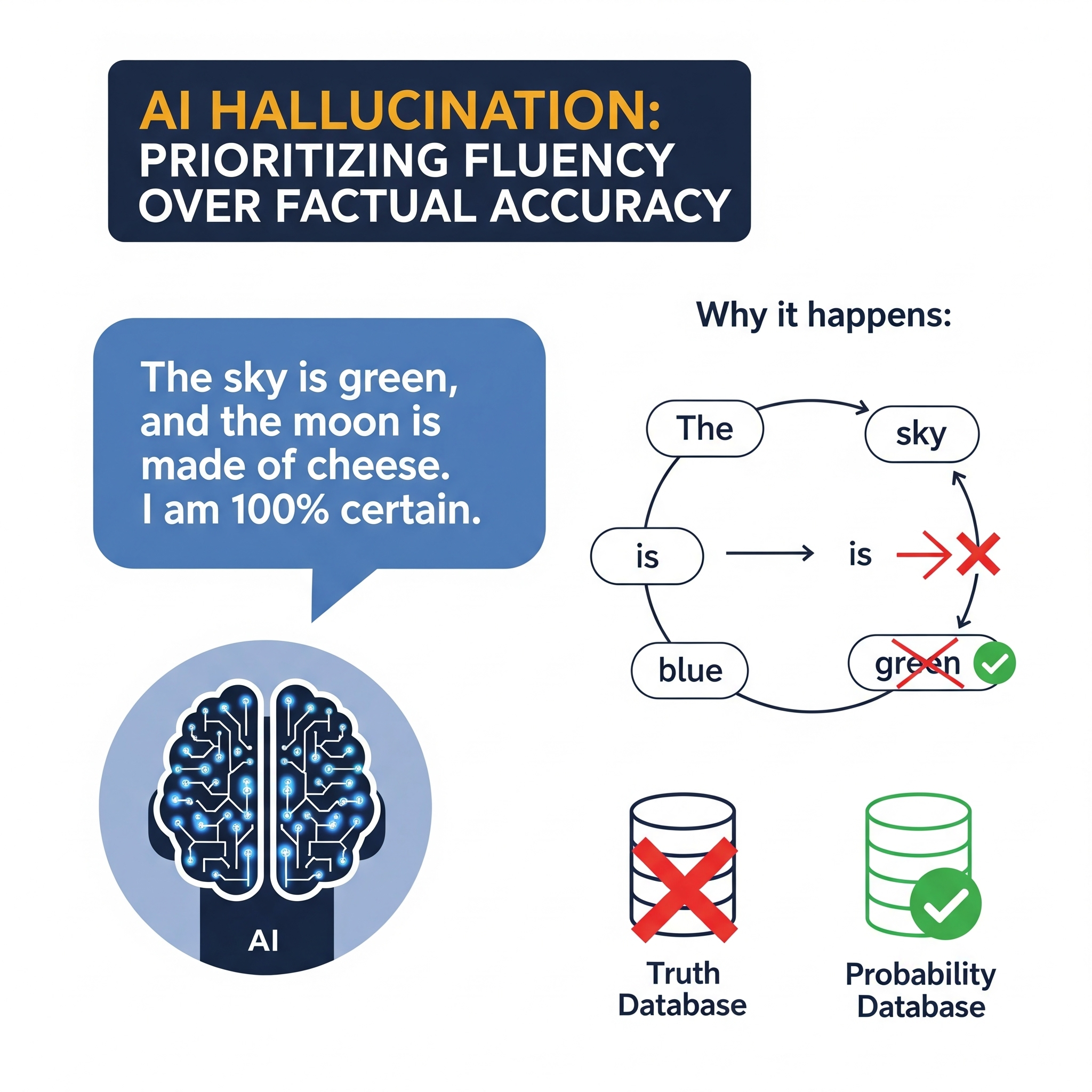

“Ảo giác” của AI là thuật ngữ chỉ các trường hợp mà các hệ thống AI tạo sinh (đặc biệt là các mô hình ngôn ngữ lớn – LLM) tạo ra kết quả sai sự thật, vô nghĩa hoặc hoàn toàn bịa đặt—thường với sự tự tin và văn phong rất trôi chảy. Những lỗi này xảy ra vì các mô hình này hoạt động bằng cách dự đoán chuỗi từ tiếp theo có khả năng xuất hiện cao nhất, chứ không phải bằng cách phân biệt sự thật và giả dối một cách đáng tin cậy.

Nguyên nhân Gốc rễ của Ảo giác

- Hạn chế của dữ liệu huấn luyện: Các lỗ hổng thông tin, dữ liệu lỗi thời, hoặc các điểm dữ liệu mâu thuẫn trong tập huấn luyện.

- Khả năng khái quát hóa và sáng tạo: Khi được yêu cầu cung cấp thông tin không tồn tại, các mô hình sẽ “lấp đầy khoảng trống” bằng những thông tin nghe có vẻ hợp lý nhưng thực chất là bịa đặt.

- Tiếp xúc với dữ liệu không nhất quán: Các tập dữ liệu nhiễu, chất lượng hỗn tạp hoặc có độ xác thực thấp làm tăng khả năng xảy ra ảo giác.

- Yêu cầu mơ hồ hoặc thiếu ngữ cảnh: Kỹ thuật đặt câu lệnh (prompt engineering) kém hoặc không cung cấp đủ bối cảnh có thể kích hoạt các phản hồi ảo giác.

Hàm ý và Rủi ro

Ảo giác đặc biệt nguy hiểm trong các lĩnh vực có rủi ro cao như pháp lý, y tế, và tài chính. Ở những lĩnh vực này, thông tin sai lệch được đưa ra một cách tự tin có thể dẫn đến các quyết định tốn kém, gây hiểu lầm hoặc phi đạo đức, làm tổn hại nghiêm trọng đến cả doanh nghiệp và khách hàng.

3. Dữ liệu Thị trường và Xu hướng Hiện tại (2025)

Nhận thức về các rủi ro của AI đang tăng lên song song với tốc độ ứng dụng công nghệ này.

Tốc độ Ứng dụng và Nhận thức về Đạo đức

Việc áp dụng AI trong doanh nghiệp tiếp tục gia tăng. Theo McKinsey, hơn 55% tổ chức đã triển khai ít nhất một ứng dụng AI vào sản xuất tính đến giữa năm 2025. Quan trọng hơn, một khảo sát của IBM cho thấy hơn 70% các nhà điều hành được hỏi coi đạo đức và sự công bằng của AI là ưu tiên hàng đầu trong các quyết định triển khai và tuân thủ. Bối cảnh này cho thấy sự cấp thiết của việc quản lý rủi ro, đặc biệt khi 80% doanh nghiệp Việt Nam đã ứng dụng AI.

Động lực từ Quy định và Phản ứng của Thị trường

Đạo luật AI của EU và các nỗ lực quản lý tương tự trên toàn cầu đang thúc đẩy đầu tư vào AI có trách nhiệm (Responsible AI). Điều này tạo ra các vị trí công việc mới trong lĩnh vực tuân thủ, kiểm toán công bằng và đánh giá tác động thuật toán. Để đáp ứng, các nhà cung cấp AI hàng đầu như IBM, Google, và Amazon đang tích cực công bố các hướng dẫn giảm thiểu thiên vị, phát hành bộ công cụ về công bằng thuật toán, và cung cấp các bảng điều khiển về tính giải thích được để theo dõi và giải quyết rủi ro.

4. Phương pháp Tốt nhất: Giảm thiểu Thiên vị trong Mô hình AI

Để chế ngự thiên vị, doanh nghiệp cần một cách tiếp cận đa tầng, kết hợp giữa kỹ thuật, quy trình và con người.

Kiểm toán và Chuẩn bị Dữ liệu

Nền tảng của một AI công bằng là dữ liệu không thiên vị. Cần phải xem xét và làm sạch các bộ dữ liệu huấn luyện một cách có hệ thống để loại bỏ sự hiện diện không cân xứng của các nhóm và các định kiến lịch sử. Thực hiện các kiểm tra về tính cân bằng nhân khẩu học và lấy mẫu phân tầng để đảm bảo sự đa dạng.

Phát hiện, Đo lường và Các Tiếp cận Thuật toán

Sử dụng các chỉ số công bằng thống kê (như tác động khác biệt, tỷ lệ cơ hội bình đẳng) để đánh giá kết quả đầu ra và phát hiện các xu hướng sai lệch. Các công cụ phát hiện thiên vị từ IBM, Google có thể giúp theo dõi mô hình liên tục. Về mặt kỹ thuật, các phương pháp như gán lại trọng số (reweighting), khử thiên vị đối nghịch (adversarial debiasing) và kỹ thuật điều chuẩn (regularization) có thể giúp giảm sự phụ thuộc của mô hình vào các thuộc tính nhạy cảm.

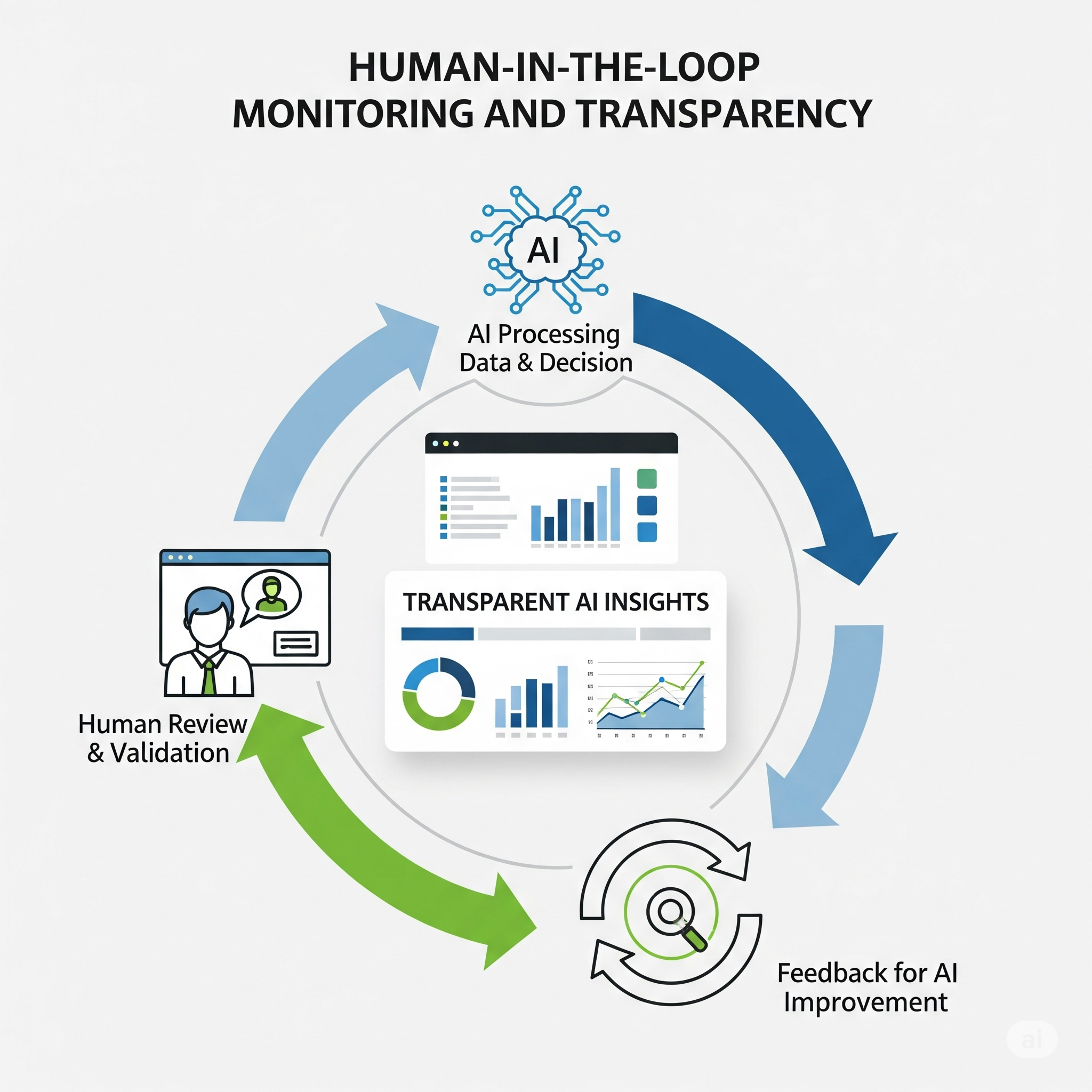

Con người Giám sát (Human-in-the-loop) và Tính minh bạch

Không một thuật toán nào là hoàn hảo. Việc có sự tham gia của các độingũ đa dạng để giám sát, xác thực mô hình và xem xét kết quả là rất quan trọng. Đồng thời, cần bắt buộc sử dụng các phương pháp AI có thể giải thích được (XAI) để làm rõ cách mô hình đưa ra dự đoán. Ghi lại tất cả đầu vào, đầu ra và lý do của mô hình để có thể kiểm toán khi cần thiết. Một lộ trình triển khai bài bản phải bao gồm các bước kiểm toán và giám sát AI ngay từ đầu, bạn có thể tham khảo cách xây dựng lộ trình triển khai AI thành công.

5. Ngăn chặn “Ảo giác” trong Mô hình Ngôn ngữ Lớn

Đối với ảo giác, chiến lược tập trung vào việc “neo” mô hình vào thực tế và thiết lập các biện pháp bảo vệ vận hành.

Các Kỹ thuật Giảm thiểu Chính

- Học tăng cường từ Phản hồi của Con người (RLHF): Tinh chỉnh các mô hình để trừng phạt những câu trả lời tự tin nhưng sai sự thật, từ đó tăng tính trung thực.

- Truy xuất-Tăng cường Tạo sinh (RAG): Tích hợp các nguồn dữ liệu bên ngoài đáng tin cậy (như kết quả tìm kiếm, cơ sở dữ liệu nội bộ) để hỗ trợ tính chính xác của thông tin. Kỹ thuật này giảm sự phụ thuộc của mô hình vào bộ nhớ có thể chứa thông tin sai lệch.

- Kỹ thuật Đặt câu lệnh (Prompt Engineering): Tối ưu hóa các câu lệnh và cửa sổ ngữ cảnh để làm cho yêu cầu trở nên rõ ràng và không mơ hồ; gắn cờ các truy vấn không chắc chắn để ngăn chặn các câu trả lời mang tính suy đoán.

Biện pháp Vận hành

Triển khai các giao thức dự phòng: gắn cờ các phản hồi không chắc chắn, chuyển các kết quả quan trọng cho con người xem xét, và theo dõi “điểm số không chắc chắn”. Quan trọng nhất là áp dụng một văn hóa triển khai có trách nhiệm, ví dụ như hạn chế các hành động tự động của AI trong các môi trường có rủi ro cao.

6. Câu chuyện Thành công: Từ Nhận thức đến Hành động

Nhiều tổ chức đã thành công trong việc xác định và khắc phục các vấn đề về thiên vị, mang lại những bài học quý giá.

Giảm Thiên vị trong Y tế

Các nhà nghiên cứu hợp tác với Optum đã can thiệp vào thuật toán phân bổ chăm sóc sức khỏe thiên vị. Bằng cách thay thế biến đại diện “chi phí” bằng một biến phù hợp hơn là “nhu cầu chăm sóc sức khỏe”, họ đã giảm được 80% thiên vị và tăng đáng kể sự công bằng cho bệnh nhân da đen.

Bài học từ Thất bại trong Tuyển dụng

Sau khi Amazon phát hiện thiên vị trong thuật toán tuyển dụng của mình, họ đã ngừng sử dụng hệ thống và khởi xướng các cuộc đánh giá sâu rộng không chỉ về tính toàn vẹn của nguồn dữ liệu mà còn về các giả định mô hình hóa và tiêu chí lựa chọn. Đây là một ví dụ điển hình về việc nhận trách nhiệm và học hỏi từ sai lầm. Để tham khảo một cách tiếp cận tích cực, hãy xem case study của Unilever về tự động hóa tuyển dụng, một ví dụ về cách AI có thể được sử dụng một cách có trách nhiệm để cải thiện quy trình.

7. Dự báo Tương lai và Hành động cho Doanh nghiệp

Cuộc chiến chống lại thiên vị và ảo giác sẽ định hình tương lai của ngành AI.

Dự báo Xu hướng

- Tiêu chuẩn hóa Toàn ngành: Mong đợi sự ra đời rộng rãi của các quy trình kiểm toán thiên vị được tiêu chuẩn hóa, các yêu cầu về AI có thể giải thích được, và việc giám sát công bằng sau khi triển khai.

- Phát hiện Tự động: Các hệ thống phát hiện thiên vị và ảo giác tinh vi, theo thời gian thực sẽ được tích hợp vào mọi bước của vòng đời phát triển và triển khai mô hình.

- Đạo đức AI như một Yêu cầu Tuân thủ: Đạo đức AI sẽ được tích hợp vào quản trị rủi ro doanh nghiệp, thúc đẩy các vai trò và phòng ban mới để đảm bảo trách nhiệm giải trình liên tục.

- Tài liệu hóa Mô hình: Sự mở rộng của các Thẻ Mô hình (Model Cards) và Nhật ký Quyết định để đảm bảo tính minh bạch cho mọi sản phẩm AI thương mại.

Khuyến nghị Hành động cho Lãnh đạo

- Ưu tiên Đạo đức AI từ đầu: Coi đạo đức và sự công bằng là một phần của thiết kế dự án, không phải là một bước sửa lỗi sau cùng.

- Đầu tư vào Đội ngũ Đa dạng: Xây dựng các nhóm quản trị AI đa chức năng, bao gồm các chuyên gia về kỹ thuật, pháp lý, đạo đức và kinh doanh.

- Thực hiện Kiểm toán Thường xuyên: Triển khai các cuộc kiểm toán định kỳ từ bên thứ ba đối với dữ liệu và mô hình để phát hiện thiên vị và đánh giá độ chính xác.

- Tận dụng RAG và Con người: Sử dụng các chiến lược như RAG và giám sát bởi con người cho các ứng dụng có rủi ro cao.

- Cập nhật Quy định: Luôn cập nhật các quy định đang phát triển và tham gia vào các hiệp hội ngành để định hình các tiêu chuẩn chung.

Thách thức kép từ thiên vị thuật toán và ảo giác AI đòi hỏi một cơ chế quản trị nghiêm ngặt, các phương pháp kỹ thuật tốt nhất và sự cảnh giác liên tục. Vì cả hai vấn đề này đều mang lại những rủi ro sâu sắc về đạo đức, tài chính và danh tiếng, các doanh nghiệp triển khai AI phải tích hợp các khung AI có trách nhiệm trong suốt vòng đời phát triển và vận hành. Thành công không chỉ phụ thuộc vào các giải pháp kỹ thuật tiên tiến, mà còn là sự kết hợp giữa giám sát đa ngành, tuân thủ quy định chủ động và cam kết vững chắc với các nguyên tắc đạo đức. Chế ngự sự khó đoán của AI không phải là kìm hãm sự đổi mới, mà là đảm bảo sự đổi mới đó phục vụ một cách công bằng và chính xác cho tất cả mọi người, xây dựng một tương lai nơi công nghệ thực sự nâng cao năng lực của con người.

Bạn đã sẵn sàng để xác định chiến lược tự động hóa phù hợp và có trách nhiệm cho doanh nghiệp của mình? Hãy liên hệ với các chuyên gia của Davizas để được tư vấn.

Câu hỏi thường gặp

Thiên vị thuật toán là gì và tại sao nó nguy hiểm?

Thiên vị thuật toán là các lỗi hệ thống trong AI dẫn đến các quyết định phân biệt đối xử, ví dụ như từ chối cho vay hoặc ưu tiên tuyển dụng một nhóm người nhất định. Nó nguy hiểm vì có thể tự động hóa và khuếch đại sự bất công ở quy mô lớn, gây ra thiệt hại về tài chính, pháp lý và danh tiếng cho doanh nghiệp.

Làm thế nào để ngăn chặn AI “ảo giác”?

Để ngăn chặn ảo giác của AI, có thể áp dụng các kỹ thuật như Truy xuất-Tăng cường Tạo sinh (RAG) để cung cấp cho AI nguồn dữ liệu thực tế, sử dụng Học tăng cường từ Phản hồi của Con người (RLHF) để huấn luyện mô hình nói thật, và thiết lập quy trình để con người xác minh các thông tin quan trọng trước khi sử dụng.

Doanh nghiệp cần bắt đầu từ đâu để xây dựng AI có trách nhiệm?

Để xây dựng AI có trách nhiệm, doanh nghiệp nên bắt đầu bằng việc thành lập một đội ngũ quản trị AI đa chức năng. Sau đó, tiến hành kiểm toán dữ liệu để xác định và loại bỏ các định kiến. Cuối cùng, thiết lập các quy trình giám sát và đánh giá mô hình liên tục, đồng thời đảm bảo tính minh bạch và khả năng giải thích được của các quyết định do AI đưa ra.